Penulis

Akira Noda - VoicePing Inc.TL;DR

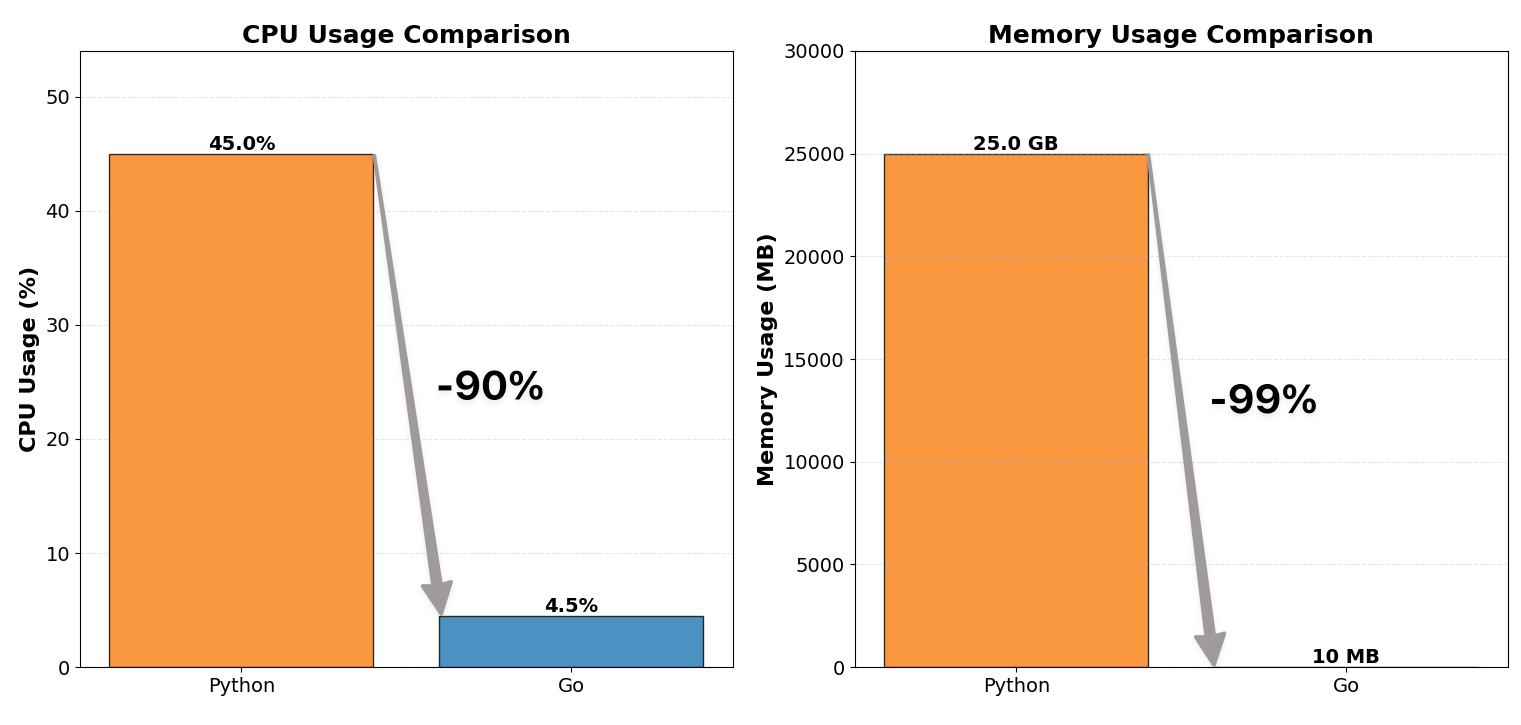

Kami menulis semula pelayan proksi WebSocket kami dari Python ke Go dan mengurangkan penggunaan CPU kepada 1/10 dan penggunaan memori kepada 1/100. Projek ini bukan sahaja meningkatkan kecekapan sumber tetapi juga mengajar kami pelajaran keserentakan yang penting:Pastikan kunci sekecil dan sesedikit mungkin.

Konteks

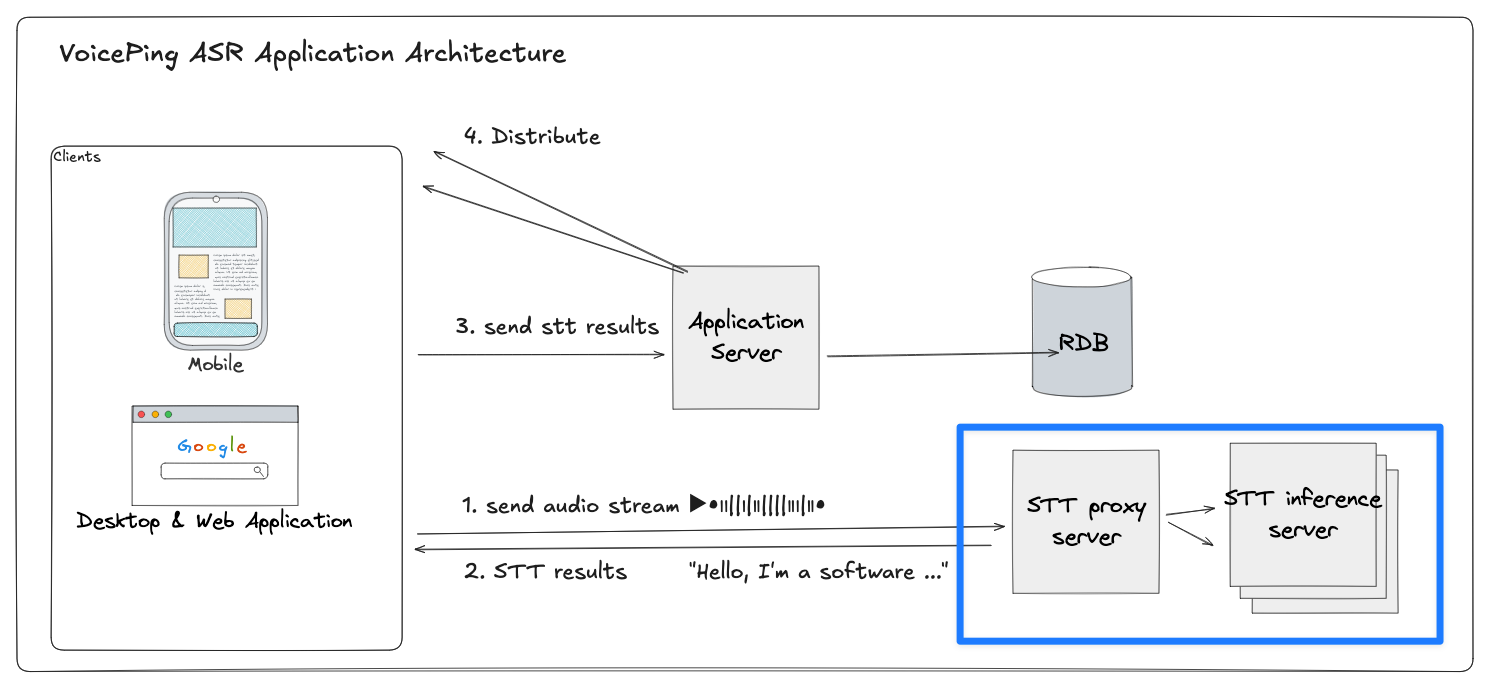

Sistem kami adalah saluran paip STT (pertuturan-ke-teks) dan terjemahan masa nyata yang digunakan dalam VoicePing, di mana setiap peranti klien mengalirkan audio ke backend kami untuk pertuturan-ke-teks dan terjemahan dalam pelbagai bahasa. Pelayan proksi WebSocket berada di tengah saluran paip ini:

Gambaran keseluruhan seni bina sistem

- Setiap klien mengekalkan sesi WebSocket berterusan dengan proksi STT

- Proksi menyampaikan paket audio ke salah satu daripada beberapa pelayan inferens berasaskan GPU

- Menunggu teks yang ditranskripsikan dan mengalirkan balik transkrip separa dan terjemahan

Sebelum: Proksi Python (Tidak Cekap)

Pelayan proksi pertama kami dilaksanakan dalam Python (FastAPI + asyncio + websockets) dan digunakan menggunakan Gunicorn dengan berbilang proses pekerja. Ia berfungsi dengan baik pada skala kecil tetapi dengan cepat mencapai had sumber di bawah trafik pengeluaran:| Metrik | Sebelum (Python) | Selepas (Go) |

|---|---|---|

| Penggunaan CPU | ~12 teras, 40-50% | ~12 teras, 4-5% |

| Penggunaan memori | ~25 GB | ~10 MB |

Mengapa Python Bergelut

Walaupun tak segerak, seni bina Python mengenakan beberapa bottleneck sistemik: Event Loop Single-Threaded: Model asyncio menggandakan ribuan coroutine pada satu thread. Ini bermakna hanya satu coroutine berjalan pada satu masa - yang lain menunggu sehingga gelung menyerahkan kawalan. Di bawah I/O yang berat, gelung tunggal ini menjadi titik cekik pusat, terutamanya untuk beban kerja WebSocket dengan peristiwa baca/tulis yang berterusan. Gunicorn Multiprocessing: Untuk menggunakan semua teras CPU, kami mencipta berbilang proses pekerja. Setiap proses memuatkan runtime Python penuh dan keadaan aplikasi - menggandakan penggunaan memori secara linear. Konteks Tugas Berat: Setiap sambungan WebSocket menyimpan bingkai tindanan, futures, dan callbacks sendiri - menggunakan memori yang besar setiap sambungan. Overhead Interpreter: Setiap coroutine berjalan di dalam interpreter CPython, menambah pemeriksaan jenis dinamik dan overhead penghantaran bytecode. Akibatnya, walaupun sistem kelihatan serentak, ia berurutan pada terasnya - setiap coroutine menunggu pada event loop yang sama, memperbesarkan latensi dan beban CPU apabila kiraan sambungan meningkat. Ia tidak dapat dielakkan - model Python tidak sesuai untuk multiplexing WebSocket yang berumur panjang, throughput tinggi, latensi rendah pada skala ini. Jadi kami menulis semula dalam Go.Pandangan Burung Pelayan Proksi

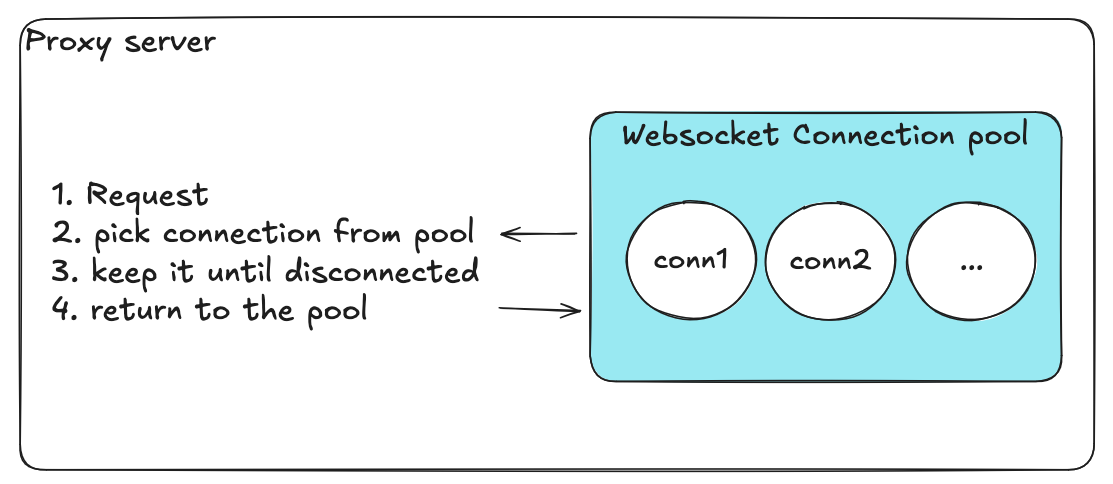

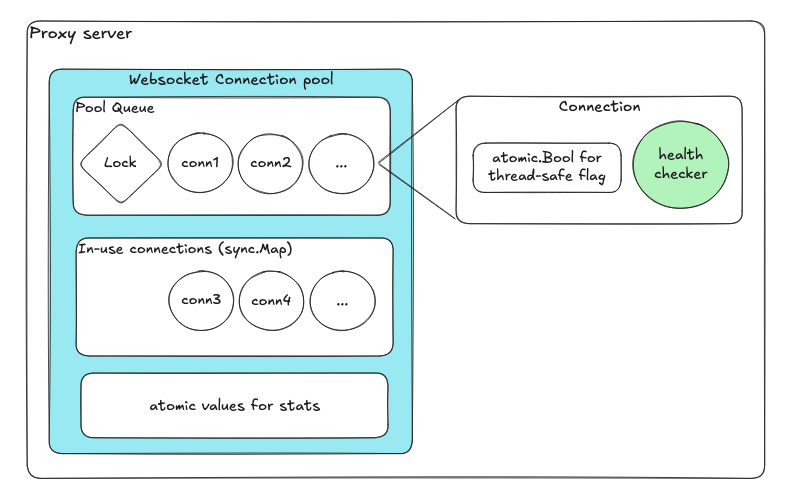

Seni bina pelayan proksi dengan kumpulan sambungan

- Pengurus sambungan: mengendalikan penghalaan dan kitaran hayat sambungan klien

- Kumpulan sambungan WebSocket: mengurus sambungan backend boleh guna semula untuk setiap pelayan inferens

- Mengimbangi beban dengan cekap merentasi pelayan inferens

- Mengelakkan overhead penubuhan sambungan yang kerap

Keperluan Fungsi untuk Pengurusan Kumpulan Sambungan

Keperluan fungsi kumpulan sambungan

| Keperluan | Tujuan |

|---|---|

| Pilih sambungan yang tersedia | Setiap permintaan masuk mesti mendapatkan sambungan backend yang siap digunakan dengan cepat tanpa menyekat klien lain. Memastikan latensi rendah dan pengimbangan beban yang lancar. |

| Kembalikan sambungan ke kumpulan | Sebaik sahaja sesi klien tamat, sambungan harus dilepaskan dan disediakan untuk digunakan semula. Meminimumkan overhead membuka/menutup sambungan berulang kali. |

| Simpan hanya sambungan yang sihat | Pemeriksaan kesihatan berkala membuang atau mencipta semula sambungan yang gagal. Menghalang sambungan tidak sihat daripada terkumpul dan menyebabkan kegagalan senyap. |

| Segerakkan konfigurasi pangkalan data | Menyegerakkan konfigurasi sambungan backend secara berkala dari pangkalan data pusat, membenarkan penskalaan dinamik tanpa memulakan semula. |

Reka Bentuk Pertama (Naif)

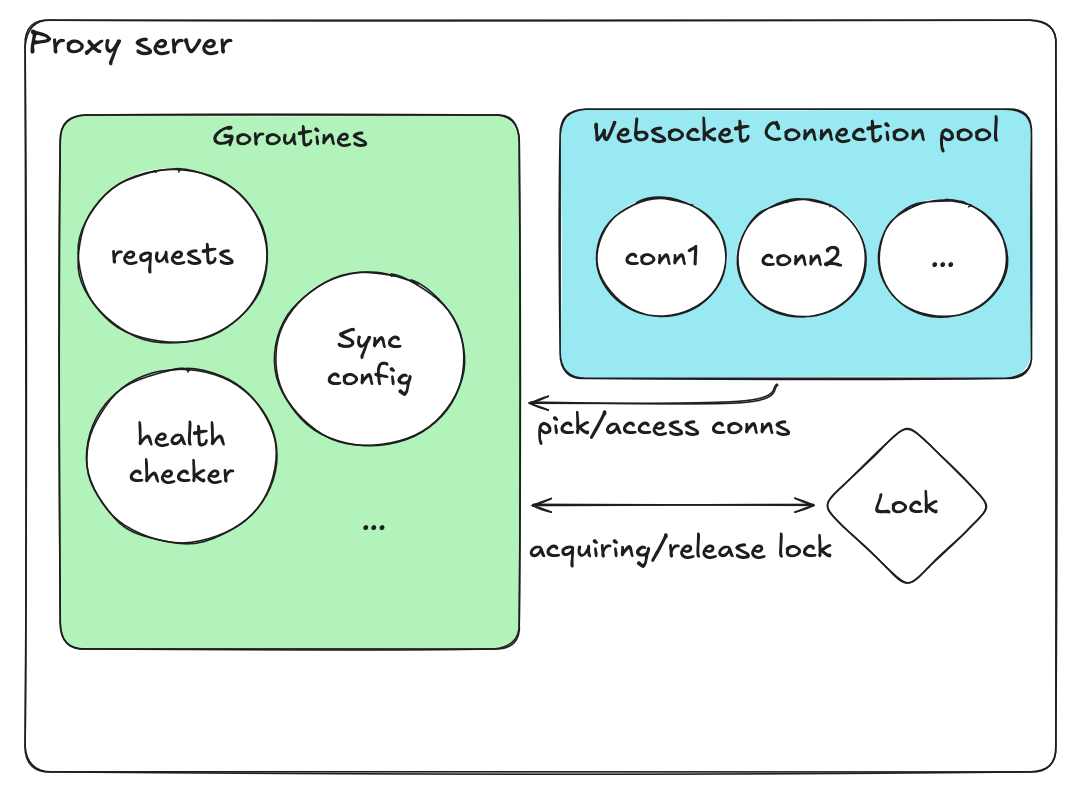

Reka bentuk awal dengan mutex global

- Satu tatasusunan yang memegang semua sambungan

- Bendera Boolean untuk keadaan “sedang digunakan” / “tersedia”

- Satu kunci global untuk semua operasi

- Mendapatkan kunci

- Mengimbas tatasusunan untuk mencari sambungan yang tersedia

- Menandakannya sebagai “sedang digunakan”

- Melepaskan kunci

Isu dalam Reka Bentuk Pertama

Walaupun berfungsi dalam ujian kecil, model pengumpulan awal rosak di bawah beban. Kami memerhati: Kiraan jumlah tidak betul (terlebih/terkurang): Operasi pilih/kembalikan serentak mengubah slice + bendera yang sama di bawah satu kunci kasar, jadi percubaan semula dan timeout kadangkala mengembalikan dua kali atau kehilangan sambungan, melepasi maksimum atau menyebabkan kumpulan kebuluran. Akses serentak bertembung -> ranap & keadaan rosak: Pemeriksaan kesihatan dan goroutine metrik bertembung dengan pengendali permintaan; pemeriksaan kesihatan yang panjang memegang kunci global, sementara pembaca kadangkala memerhatikan bendera separuh dikemas kini, mencetuskan panik atau ralat “tiada sambungan tersedia” walaupun kapasiti ada. Kebocoran goroutine: Dail gagal dan pemeriksaan kesihatan timeout tidak selalu dibatalkan atau dituai; percubaan semula mencipta goroutine baharu sementara rujukan kepada yang lama kekal. Kebolehperhatian rapuh: Pembilang yang diperoleh dari slice + bendera kerap tidak bersetuju dengan realiti, menjadikan amaran bising dan menutup insiden sebenar. Pertembungan kunci & lonjakan latensi: Imbasan O(n) untuk slot yang tersedia di bawah satu kunci memperbesarkan latensi ekor apabila keserentakan meningkat.Reka Bentuk Disemak

Reka bentuk tanpa kunci dengan atomik dan saluran

| Komponen | Tujuan |

|---|---|

| Baris gilir untuk sambungan tersedia | Enqueue/dequeue mengendalikan kunci dalaman secara automatik |

| sync.Map untuk sambungan sedang digunakan | Peta serentak tanpa kunci |

| Pemboleh ubah atomik | Bendera kesihatan dan pembilang |

| Goroutine khusus setiap sambungan | Pemeriksaan kesihatan bebas |

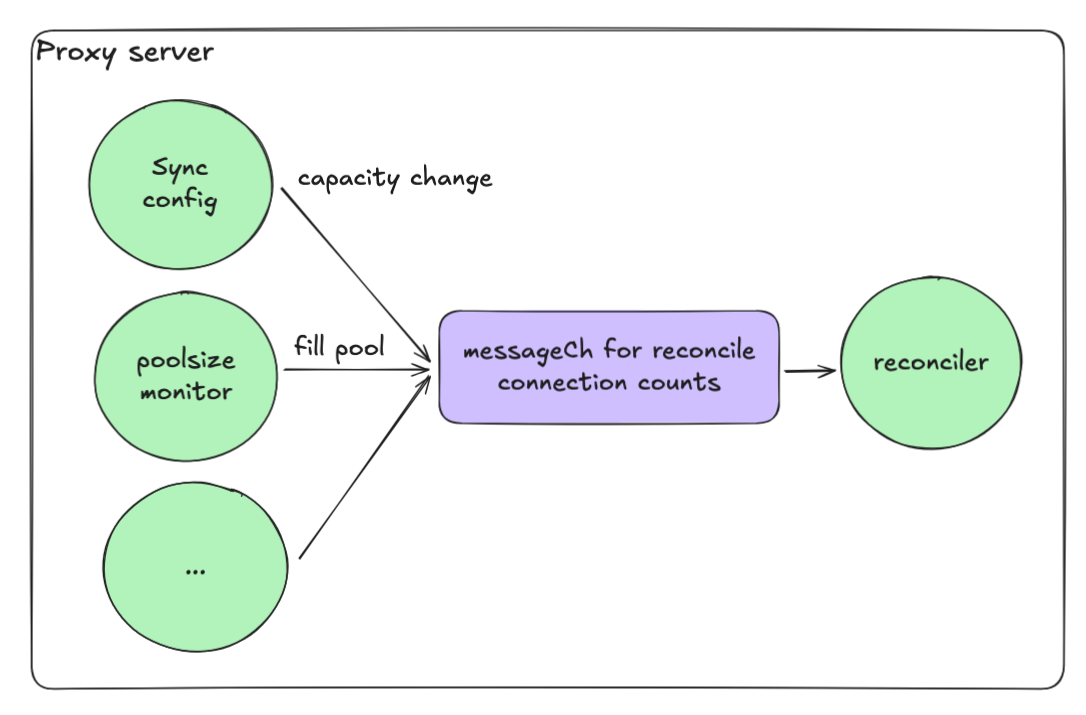

Penyesuaian Dipacu Peristiwa

Corak pekerja penyesuaian

- Setiap operasi menghantar mesej ke dalam saluran (messageCh)

- Goroutine penyesuaian memproses mesej-mesej ini secara berurutan

- Ini memastikan tiada keadaan perlumbaan

- Pekerja single-threaded menserialisasikan penyesuaian

- Saluran buffer menggabungkan lonjakan menjadi operasi tunggal

- Jaring keselamatan berkala dengan jitter menghalang kawanan menggerunkan

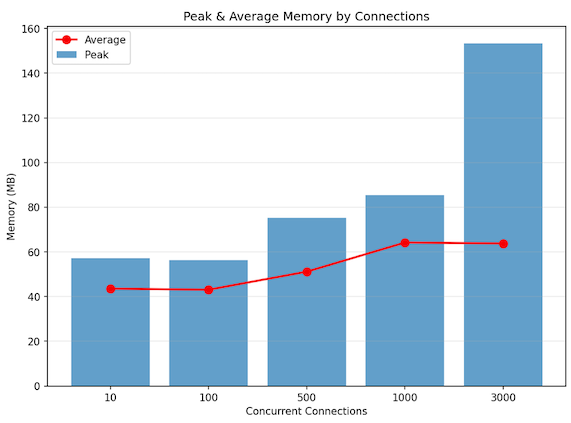

Semakan Prestasi Tempatan

Persediaan dan keputusan ujian prestasi tempatan

Persediaan Ujian

| Komponen | Konfigurasi |

|---|---|

| Proksi | Proksi WebSocket berasaskan Go |

| Backend | 3 x Pelayan WebSocket Echo |

| Beban | 3,000 sambungan serentak (tiada peningkatan) |

| Trafik | Mesej teks 1 KB @ 100 msg/s setiap sambungan |

Keputusan

| Metrik | Nilai |

|---|---|

| Sesi serentak | ~3,000 stabil |

| Throughput | ~300K mesej/saat |

| Memori puncak | ~150 MB |

| Memori purata | ~60 MB |

| Penggunaan CPU | ~4-5% daripada 12 teras |

Ringkasan perbandingan prestasi

Kesimpulan

Selepas menggunakan proksi berasaskan Go baharu, kami memerhati peningkatan utama merentasi prestasi, skalabiliti, dan kestabilan:| Kategori | Python (FastAPI + asyncio + Gunicorn) | Go (Goroutines + Channels + Atomics) | Peningkatan |

|---|---|---|---|

| Penggunaan CPU | ~12 teras x 40-50% | ~12 teras x 4-5% | ~90% pengurangan |

| Penggunaan memori | ~25 GB | ~60-150 MB | ~99% pengurangan |

| Skalabiliti | Terhad kepada ratusan | Menampung ribuan | 10x skala |

Pengambilan Utama: Reka bentuk keserentakan sebagai proses bebas yang berkomunikasi - bukan sebagai keadaan boleh ubah dikongsi di bawah perlindungan.

Rujukan

- Go Concurrency Patterns - golang.org/doc/effective_go

- gorilla/websocket - github.com/gorilla/websocket

- Python asyncio Event Loop - docs.python.org